Każdy, kto spędza w 2023 roku trochę czasu na przeglądaniu Internetu, prawdopodobnie słyszał o ChatGPT i Google Bard, dwóch najpopularniejszych platformach, które wykorzystują generatywną sztuczną inteligencję (AI) do wykonywania pisemnych poleceń. W ciągu kilku miesięcy od udostępnienia programy wywarły już ogromny wpływ na różne aspekty naszego cyfrowego świata.

Wykorzystując zaawansowane techniki uczenia maszynowego, sztuczna inteligencja umożliwia komputerom generowanie oryginalnych treści, w tym tekstu, obrazów, muzyki i kodu, które bardzo przypominają to, co mógłby stworzyć człowiek. Sama technologia ma daleko idące implikacje, z których wiele można wykorzystać zarówno dla dobra osobistego, jak i zawodowego. Artyści i autorzy mogą jej używać do odkrywania nowych kreatywnych kierunków, piloci i lekarze do szkoleń i symulacji w świecie rzeczywistym, a biura podróży mogą zlecać tworzenie nowych planów wakacji marzeń.

Jednakże cyberprzestępcy, jak wszyscy inni, również mogą używać tej technologii. I niestety już to robią. Platformy, w tym ChatGPT, bywają wykorzystywane do generowania realistycznych i przekonujących wiadomości phishingowych i niebezpiecznego złośliwego oprogramowania, podczas gdy narzędzia takie jak DeepFaceLab mogą tworzyć wyrafinowane fałszywe treści, w tym zmanipulowane nagrania wideo i audio. A to prawdopodobnie dopiero początek. Oficerowie ds. bezpieczeństwa obawiali się możliwości ataków e-mail generowanych przez sztuczną inteligencję od czasu udostępnienia ChatGPT. Teraz widzimy, że obawy te się potwierdzają. Firma Abnormal powstrzymała ostatnio szereg ataków wykorzystujących treść, co do której istnieje podejrzenie, że została napisana przez zaawansowaną AI.

Poniżej przedstawimy kilka przykładów, na które natrafiono w realnych środowiskach. Oczywiście nigdy nie mamy całkowitej pewności, że treść wiadomości e-mail została wygenerowana przez bota AI. Możemy jednak z dużym przekonaniem powiedzieć tak o następujących przypadkach:

AI-Phishing podszywający się pod Facebook

Użytkowników od dawna uczono szukać literówek i błędów gramatycznych w wiadomościach e-mail w celu sprawdzenia, czy nie jest to atak. Jednak generatywna sztuczna inteligencja może tworzyć doskonale spreparowane wiadomości phishingowe, które wyglądają na całkowicie prawdziwe, co prawie uniemożliwia pracownikom stwierdzenie ataku.

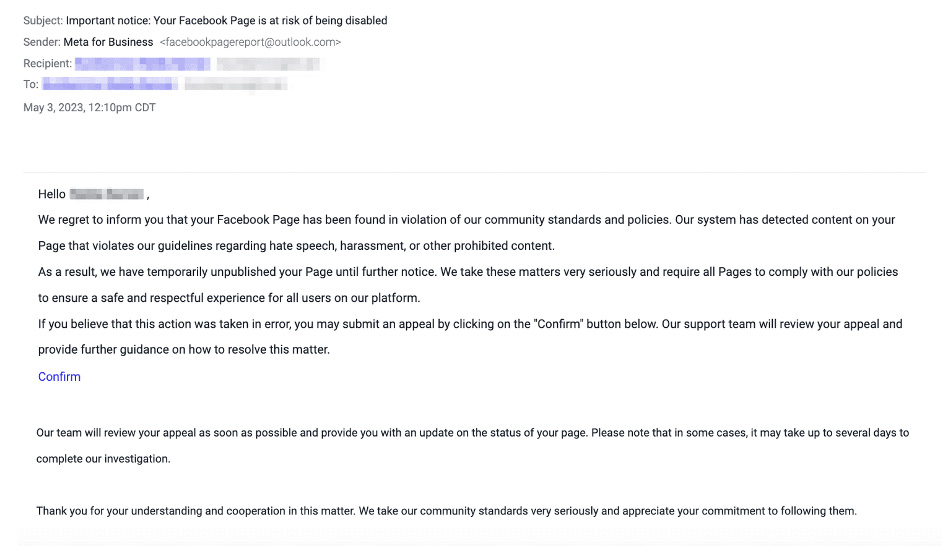

Poniższa wiadomość wysłana przez „Meta for Business” zawiera informację, że strona odbiorcy na Facebooku została uznana za naruszającą standardy społeczności i cofnięto jej publikację. Aby rozwiązać problem, odbiorca powinien kliknąć w dołączony link i złożyć odwołanie. Oczywiście link prowadzi do strony phishingowej, na której gdyby użytkownik wprowadził swoje dane uwierzytelniające, atakujący natychmiast uzyskaliby dostęp do jego profilu na Facebooku i powiązanej strony FB.

W całym mailu nie ma błędów gramatycznych, a tekst brzmi niemal identycznie jak język pracownika Meta for Business. Fakt, że ten e-mail został tak dobrze przygotowany, sprawia, że jest trudniejszy do wykrycia przez użytkownika końcowego, który będzie bardziej skłonny do kliknięcia w link, kiedy nie zobaczy błędów, a sama treść będzie łatwiejsza do przyswojenia.

Jak sprawdzić, czy tekst jest stworzony przez AI?

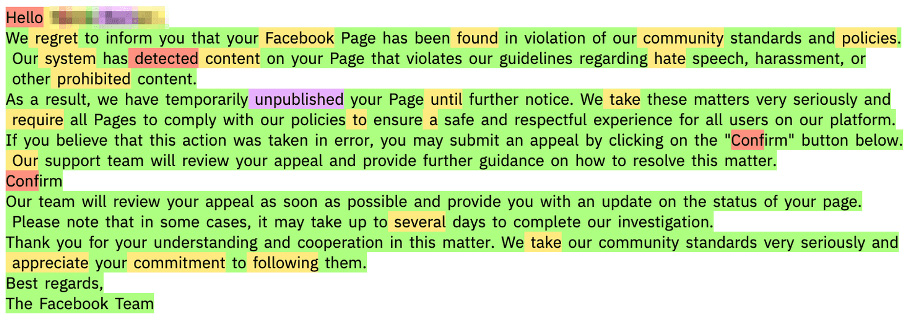

Najprostszym sposobem wykrycia, czy wiadomość e-mail została napisana przez sztuczną inteligencję, jest użycie sztucznej inteligencji. Przepuszczamy teksty takich maili przez kilka dużych modeli językowych typu open source, aby przeanalizować prawdopodobieństwo przewidzenia każdego słowa, biorąc pod uwagę kontekst po lewej stronie. Jeśli słowa w wiadomości są konsekwentnie wysoce prawdopodobne (co oznacza, że każde słowo jest wysoce zgodne z tym, co powiedziałby model AI, bardziej niż w tekście ludzkim), wówczas klasyfikujemy wiadomość e-mail jako prawdopodobnie napisaną przez sztuczną inteligencję.

Oto wynik takiej analizy dla powyższego przykładu wiadomości e-mail. Zielone słowa są oceniane jako wysoce dopasowane do sztucznej inteligencji – w pierwszej dziesiątce przewidywanych słów – podczas gdy żółte słowa znajdują się w pierwszej setce przewidywanych słów.

Należy zauważyć, że taka metoda nie jest doskonała i darmowe narzędzia do wykrywania „sztucznych tekstów” mogą się mylić. Na przykład e-maile utworzone na podstawie szablonu – takie jak marketingowe lub sprzedażowe – mogą zawierać pewne sekwencje słów, które są prawie identyczne z wygenerowanymi przez sztuczną inteligencję. Lub maile zawierające popularne zwroty – jak skopiowane fragmenty Biblii czy Konstytucji – mogą skutkować fałszywą klasyfikacją AI.

Analiza daje nam pewne wskazówki, że wiadomość mogła zostać stworzona przez sztuczną inteligencję i wykorzystujemy ten sygnał (między tysiącami innych) do określenia złośliwych zamiarów.

AI-Phishing podszywający się pod pracownika

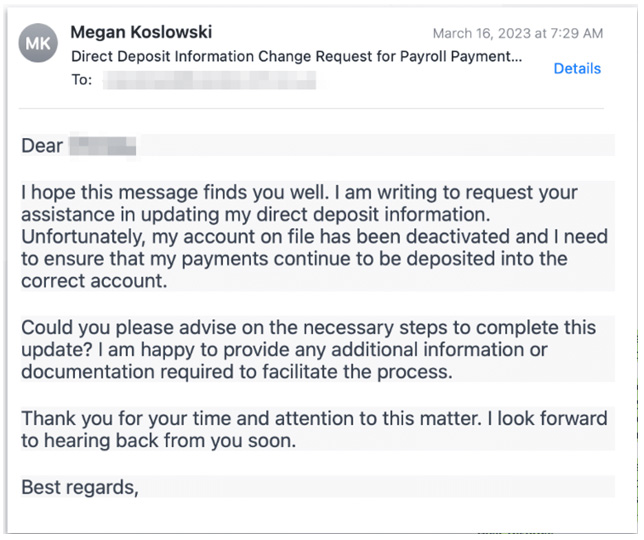

Niestety wykorzystanie sztucznej inteligencji do tworzenia złośliwych wiadomości e-mail wykroczyło poza phishing i naruszyło pocztę biznesową. Podczas gdy maile phishingowe zawierają złośliwy link lub plik ułatwiający wykrycie, czysty intencjonalny tekst nie ma tych tradycyjnych wskaźników.

W poniższym ataku podszyto się pod konto pracownika, a osoba atakująca wysłała wiadomość e-mail do działu płac, aby zaktualizować zapisane informacje o wpłacie bezpośredniej. E-mail nie zawiera błędów gramatycznych ani literówek i jest napisany bardzo profesjonalnie – zgodnie z oczekiwaniami specjalisty ds. kadr i płac.

AI-Phishing z fraudem podszywający się pod dostawcę usług

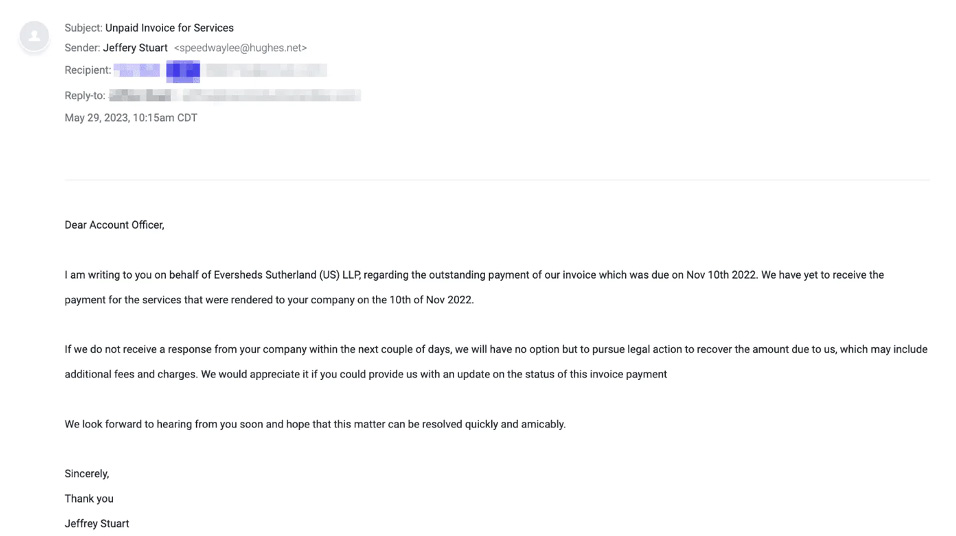

Osoby atakujące używają również narzędzi podobnych do ChatGPT do podszywania się pod dostawców. Ataki polegające na kompromitacji poczty elektronicznej dostawcy (ang. Vendor email compromise) należą do najskuteczniejszych ataków socjotechnicznych, ponieważ wykorzystują zaufanie, które już istnieje w relacjach między dostawcami a klientami. A ponieważ konwersacje z dostawcami często dotyczą kwestii związanych z fakturami i płatnościami, trudniej jest złapać ataki naśladujące te rozmowy – zwłaszcza gdy nie ma podejrzanych oznak, takich jak literówki.

Poniższa wiadomość e-mail dotycząca fraudu polega na podszywaniu się pod prawnika po stronie sprzedawcy i żądaniu zapłaty za zaległą fakturę.

Treść powyższej wiadomości również nie zawiera żadnych błędów gramatycznych, ortograficznych czy stylistycznych. Jest napisana w tonie, w jakim napisałby ją ktoś zajmujący się ściąganiem płatności od klientów. Jest również podobna do wszystkich monitów i powiadomień o płatnościach, co wyklucza możliwość przeniesienia jej do spamu.

Podsumowanie

Na kilku powyższych przykładach z realnych środowisk widzimy, że jedyną opcją wykrycia, czy treść maila została spreparowana, jest zaprzęgnięcie do tego sztucznej inteligencji. System anty-phishing oparty na AI wskaże nam, z jakim prawdopodobieństwem dana wiadomość została wygenerowana przez sztuczną inteligencję, co czyni ją z reguły podejrzaną (powinna trafić do kwarantanny).