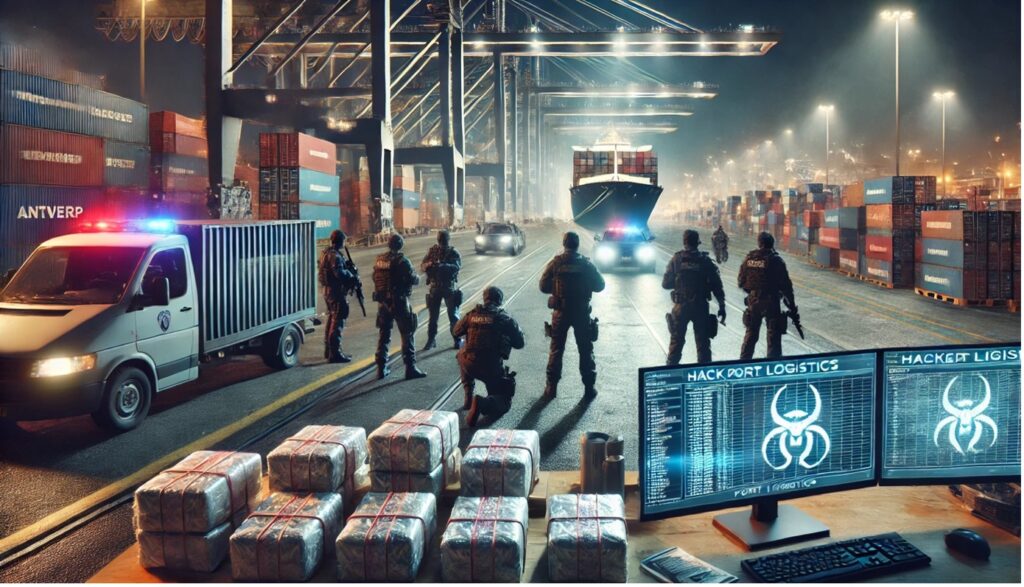

Jak specjaliści cyberbezpieczeństwa zostali członkami gangu

W dzisiejszym tekście postanowiliśmy wziąć na tapet ciekawą historię, która rozegrała się w latach 2011-2013. Może ona stanowić dobry materiał edukacyjny dla firm, które nie martwią się o zapewnienie...