Jak niezwykle prostym sposobem można oszukać autopilota AI w Tesli

Krążące w sieci nagranie ujawniło słabości systemu wspomagania kierowcy „Autopilot” Tesli, opierającego się na kamerach. Amerykański youtuber i były inżynier NASA Mark Rober opublikował film, w którym porównuje technologie wspomagania jazdy bazujące na kamerach oraz na laserowym systemie LiDAR, stosowanym w nowoczesnych pojazdach autonomicznych.

Prosty sposób na oszukanie sztucznej inteligencji w Tesli

O hakowaniu samochodów pisaliśmy na Kapitanie wielokrotnie. Wspomniany film obnaża słabości sztucznej inteligencji użytej do autonomicznego sterowania Teslą i stawia pod znakiem zapytania bezpieczeństwo takich systemów.

Eksperyment przeprowadzony przez Marka Robera miał na celu sprawdzenie, jak systemy autonomiczne samochodów radzą sobie z nietypowymi i potencjalnie niebezpiecznymi sytuacjami na drodze.

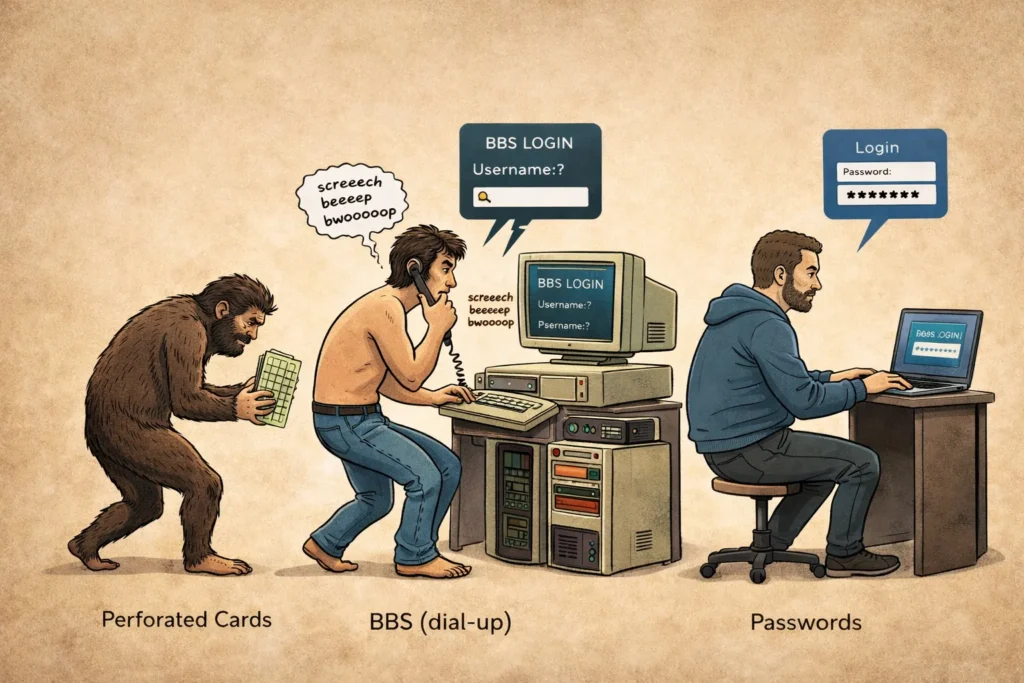

W jednym z testów na jezdni umieszczono specjalnie zaprojektowaną płachtę z nadrukowaną iluzją drogi, prowadzącą bezpośrednio na ścianę. System autopilota Tesli, który w dużej mierze opiera się na kamerach i analizie obrazu, został wprowadzony w błąd – uznał nadrukowaną drogę za rzeczywisty pas ruchu i z pełną prędkością 64 km/h wjechał prosto w przeszkodę. Ten test pokazuje, że same kamery mogą być niewystarczające do wykrywania tego typu zagrożeń, szczególnie jeśli obrazy są odpowiednio spreparowane, tak by oszukać system.

Oblany dwukrotnie test bezpieczeństwa z dzieckiem na drodze

Kolejnym testem była symulacja sytuacji, w której dziecko niespodziewanie wbiega na ulicę. W tym celu wykorzystano manekin o ludzkich proporcjach, który nagle pojawiał się przed pojazdem w trudnych warunkach atmosferycznych, takich jak mgła czy deszcz. System Tesli nie wykrył przeszkody na czas i nie podjął żadnych działań, co doprowadziło do potrącenia manekina. W praktyce oznacza to, że autonomiczne pojazdy mogą mieć poważne problemy z szybkim reagowaniem w sytuacjach wymagających błyskawicznej interpretacji dynamicznie zmieniającego się otoczenia. W przeciwieństwie do ludzi, którzy korzystają nie tylko ze wzroku, ale także z instynktu i doświadczenia, systemy oparte wyłącznie na kamerach mogą nie radzić sobie dobrze w niesprzyjających warunkach.

Dla porównania, w tych samych testach sprawdzono pojazd wyposażony w system LiDAR (Light Detection and Ranging), który wykorzystuje laserowe czujniki do mapowania otoczenia w trzech wymiarach. LiDAR, w przeciwieństwie do kamer, nie bazuje na analizie obrazu, lecz na precyzyjnym pomiarze odległości do obiektów, co sprawia, że jest bardziej odporny na iluzje optyczne, złe warunki oświetleniowe i pogodowe. Pojazd wyposażony w LiDAR prawidłowo wykrył zarówno namalowaną iluzję drogi, jak i nagle pojawiające się dziecko, unikając kolizji. Eksperyment Marka Robera podkreśla więc istotny problem w obecnych systemach autonomicznych – jeśli bazują one jedynie na kamerach i algorytmach przetwarzania obrazu, mogą być podatne na błędy prowadzące do groźnych wypadków. Wdrożenie bardziej zaawansowanych technologii, takich jak LiDAR czy radar, mogłoby znacząco zwiększyć bezpieczeństwo autonomicznych pojazdów na drogach.

Porównanie testów bezpieczeństwa i wykrywania przeszkód na drodze w różnych warunkach jazdy z wykorzystaniem systemu LiDAR vs. analiza obrazu przez AI w Tesli przedstawia poniższe porównanie.

Źródło: YouTube/Mark Rober

Dlaczego Tesla nie używa LiDAR?

Tesla zdecydowała się zrezygnować z sensorów LiDAR na rzecz systemu opartego wyłącznie na rozpoznawaniu obrazu (computer vision). Powodów tej decyzji jest kilka – LiDAR to kosztowna technologia, generująca ogromne ilości danych do przetworzenia i często pełniąca jedynie funkcję uzupełniającą dla kamer. Elon Musk otwarcie skrytykował to rozwiązanie, określając LiDAR jako „zadanie dla głupca”.

Choć Tesla uznaje rozwój tej technologii za zbędny i nieopłacalny, decyzja ta budzi kontrowersje w kontekście bezpieczeństwa zarówno pasażerów, jak i pieszych. Ograniczenie systemu autonomicznej jazdy wyłącznie do kamer zwiększa ryzyko błędów w trudnych warunkach drogowych. Możliwe, że ta wirtualna ściana nie będzie ostatnią przeszkodą, na której utknie Tesla.

Pełne wideo z testów zobaczysz poniżej.